lunes, 13 de abril de 2009

Conceptos básicos de informática

Las partes del ordenador que puedes golpear con un martillo (algo poco recomendable) se llaman hardware; las instrucciones de los programas que lo hacen funcionar y a las que únicamente puedes maldecir se llaman software.

• Richard P. Brennan Levitating Trains and Kamikaze Genes

Vacaciones con PC

Lo 10 programas más descargados de la historia

Limpieza “interna” para nuestro PC

Cuando nos quejamos de que el ordenador va lento, es momento de ponernos en plan limpieza general. Cada cierto tiempo, por el uso, es fácil que Windows acumule programas que nunca utilizas, los archivos temporales o duplicados, los atajos de escritorio múltiples o los gigabytes de datos que olvidas en tu disco duro. Limpiar ese viejo ordenador y darle brillo es fácil si tienes en cuenta el siguiente artículo: Top 10 Ways to Clean Up Your PC.

Windows Live Unified Installer al ataque

El nuevo software suite Windows Live de Microsoft incluye un actualizado servicio de correo electrónico, una aplicación para compartir fotos y nuevas herramientas de blog. Con estas medidas se puede ver que Microsoft no sólo planea competir con Google en el campo de la búsqueda, dónde está en mayor desventaja, sino que espera hacerlo en otros sectores del negocio.

Beta 3 del Windows Live Writer

FileZilla 3.0, también para Linux y MacOS

criterios de filtrado en la visualización de los listados de archivos/directorios, actualizaciones automáticas de la aplicación, soporte multi-idioma mejorado, incluyendo idiomas de escritura inversa (de derecha a izquierda), soporte mejorado para conexiones a través de firewalls, soporte para conexiones FTP sobre TLS/SSL (FTPS), soporte para el envío/recepción de archivos de más de 4Gb, gestión de los límites de la velocidad de transferencia, nuevos temas para la barra de herramientas y un nuevo icono para la aplicación.

Si no lo has descargado, ya estás tardando en descargarlo.

CCleaner, limpieza a fondo

Después de la instalación, podemos ejecutar el programa sin necesidad de reiniciar. La pantalla principal es esta:

Google Maps, imposible perderse

Google Video cambia para comvertirse en buscador de videos

Mejora la velocidad de Firefox

Backup de Blogger

Igual el sueldo no le da para calcetines nuevos

Cuidado con las contraseñas

En fin, que es lógico y claro, que las claves son muy importantes. Así que dentro de esta premisa voy a aconsejar desde aquí en base a un artículo que he leído que no pongáis claves fáciles. Una clave fácil es “árbol”, “casa”, “benjamín”, “auriculares”… es decir, cualquier palabra sencilla contenida en un diccionario. También son fáciles cosas como “mario82?, “1975maria”, o “245531542?.

Expliquemos el por qué

Usando un juego de 10 caracteres numéricos (0123456789), una clave de 9 dígitos, con un ordenador normalito (siempre pondremos ejemplos con ordenadores “de casa”) se puede sacar en base a programas que generan combinaciones y prueban la clave, en unos 15 minutos.

Si usamos un juego de 26 caracteres para nuestra clave de texto (abcdefghijklmnopqrstuvwxyz), y creando una clave 7 caracteres que es la media usada, la clave la obtendríamos en poco más de 2 horas. Si en lugar de eso usamos 52 (mayúsculas y minúsculas unidas), la misma clave podría darse en unos 12 días.

Si además de 52 caracteres de letras metemos los numéricos de antes, la misma clave tardaría 42 días, y si ademas metemos símbolos de por medio, podría tardar hasta 2 años y medio.

Todos estos ejemplos con un ordenador de casa, normalito. Tomando el último ejemplo, es decir, creando una clave de 7 caracteres con un juego de 96 caracteres (letras mayúsculas, minúsculas, números y símbolos del teclado), incluso un superordenador de esos que ocupan una pared entera, tardaría hasta medio año en descifrarla sacando combinaciones.

Conclusión

Por favor, no pongais claves que sólo contengan números o letras, para programas descargables por Internet al alcance de cualquier persona, son apenas minutos lo que hacen falta para descifrarlas. Usad claves complejas con números, letras y símbolos, por ejemplo, si quieres usar la palabra árbol (porque te gustan mucho los árboles o por cualquier motivo), puedes usar claves como ArB0l (en lugar de una “o” es un cero), o también ar(BOL)… en fin, muchas más que un simple arbolillo.

ser geek es malo para la salud

¿Por qué surgen estos problemas? Pues una de las cosas que se deben evitar es despertarse en mitad de la noche y conectarse al PC portátil o enceder la televisión. La cama sólo debe usarse para dos cosas: dormir y sexo. Si uno se pasa más de diez o quince minutos despierto en la cama, hay que levantarse y optar por leer o escuchar música. Ver la tele o usar el ordenador son actividades que estimulan y despiertan aún más el celebro.Y si se hacen repetidamente, aparece el mal hábito.

Los recurrentes dolores de cabeza son otro de los padecimientos más frecuentes entre los usuarios de PC a tiempo completo. Si sobreviene a las mismas horas del día y no aparecen durante jornadas no laborales, hay en efecto un claro culpable: el ordenador. Malas posiciones ante la pantalla, fuentes de letra demasiado pequeñas, etc, son causas de cefaleas crónicas.

Qué decir del dolor de espalda. En el común de los mortales es a menudo síntoma de depresión, pero si hablamos de geeks suele ser debido a malas condiciones de trabajo o a abusos en este sentido. Las sillas cutres y los monitores mal colocados hacen estragos. Lo peor es que cuando más se nota es durante los fines de semana, cuando lós múculos y todo l cuerpo en general se relajan más.

La capacidad de atender de muchos geeks es sumamente pobre. Cuando no están frente a la pantalla les cuesta un mundo mantenerse despiertos, por Ejemplo en reuniones largas o realizando tareas no relacionadas con el PC. Pero siapenas duermen, y mal, ¿Cómo van a prestar atención duradera a nada?

Y es que el cerebro de un geek está hecho para desarrollar multitareas informáticas, pero no para sentarse tranquilamente y escuchar...

¿El regreso de los ordenadores tontos?

Lo cuenta The Wall Street Journal. Los ordenadores tontos, esos que son todo pantalla, teclado y ratón, y cuya mayor capacidad es la de conectarse a un servidor de red que es, en realidad, el que hace las funciones que hasta ahora desempeñan los PCs de sobremesa, vuelven a estar de moda.Las empresas pueden ahorrar hasta un 40% instalando este tipo de terminales, ya que dan menos costes (¿para qué tener un disco duro en cada ordenador, por ejemplo, si para trabajar se va a usar igualmente una unidad de red?) y ofrecen más seguridad. Lo dicho, si diriges una empresa piénsatelo; no serás el único, ya que se espera que este tipo de instalaciones va a crecer a un ritmo del 21,5%.

Abusar del e-mail disminuye la productividad

El aparentemente inofensivo comportamiento de los colegas puede causar un daño incalculable en las relaciones de equipos de trabajo y en la productividad de las empresas que tienen muchas oficinas, de acuerdo con un estudio de Cisco Systems.

Los investigadores hallaron que una confianza excesiva en el correo electrónico, fallos al responder los mensajes y el uso de métodos inapropiados de comunicación pueden dañar la confianza y obstaculizar el progreso de proyectos críticos.

Cuando los equipos de trabajo virtual rechazan la necesidad de socializar, mantener contacto visual y establecer normas de comunicación actualizadas, la confianza que se construye es frágil y fácilmente vulnerable, lo que lleva a conflictos y rupturas en las relaciones.

El estudio de Cisco, denominado Psicología de las comunicaciones empresariales efectivas en equipos de trabajo geográficamente dispersos, recomienda comprometerse con protocolos en cuanto a los tiempos de respuesta deseables y fijar reglas para la selección de los medios y de la frecuencia con los cuales se llevará a cabo la comunicación, especialmente cuando se trata de equipos de trabajo multiculturales.

Fomentar la socialización y los chats alrededor de una máquina de café virtual, usando comunicaciones espontáneas y diseñadas sobre multimedia, también ayuda a agilizar y fortalecer el desarrollo de la confianza.

Un dato relevante es que los usuarios de comunicaciones electrónicas pueden tardar más de cuatro veces en intercambiar el mismo número de mensajes que cuando se usan las comunicaciones cara a cara, especialmente en los elementos no verbales (gestos, entonación, pausas, etc.), que pueden ocupar más del 63% de las interacciones sociales dentro del intercambio cara a cara.

La confianza puede ser frágil en los equipos virtuales debido a la invisibilidad del comportamiento, que ocurre cuando los equipos no pueden observarse unos a otros: la ausencia de interacción social y el silencio virtual causado por la no respuesta a mensajes de voz y correo electrónico.

El silencio virtual de alguien que no contesta estos mensajes puede alterar el flujo de trabajo e incluso provocar suspicacias en cuanto a que la parte que está en silencio está eludiendo el trabajo.

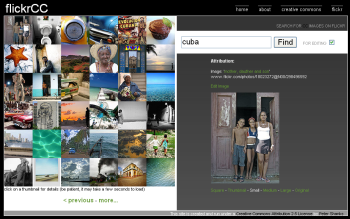

FlickrCC, imagenes Creative Commons en Flickr

A la hora de buscar imágenes que podamos usar en nuestros blogs, siempre se intenta que sean con licencia Creative Commons y un lugar dónde se suele buscar es en Flickr.

El problema es que cuando buscas en Flickr fotografías con licencia CC, te suele dar unas pocas, cuando tu intención suele ser buscar cuantas más mejor.

Alguien con un mismo problema ha creado FlickCC, que permite buscar en Flickr fotografías con licencia CC. Su uso es muy sencillo, aparecen 36 fotografías en un panel a la izquierda, el buscador a la derecha, junto a la foto seleccionada y la información de esta. Las fotos están organizadas según las más interesantes, dato dado por el voto.

Fireflix, controla tu cuenta de Flickr desde Firefox

comentarios del blog anterior

Para el punto 9, mucho mas interesante que el robot.txt es hacer un sitemap del sitio:http://google.dirson.com/o.a/google-sitemaps/

Guillo: el sitemap y el robots.txt son dos cosas distintas, el primero es para hacer un mapa del sitio y enviarlo a google (con el google sitemaps), y el segundo es un archivo muy util para todos los motores de busquedas y robots que andan por la red.

Javielinux: mencionas que hay un módulo en apache para convertir las páginas dinámicas en estáticas para los “ojos” de google, alguien sabe si existe alguna función similar en IIS???

http://www.diariothc.com/2007/02/01/optimizate-para-google/

http://www.webmasterlibre.com/2007/02/01/links-for-2007-02-01/

http://pixelco.us/blog/noticias-sobre-google/

http://wordpress.org/support/

http://geektheplanet.net/154/optimiza-tu-sitio-para-google.xhtml

http://www.pingocreative.com/

http://www.borjan.es/2007/google-ahora-le-da-mucha-importancia-al-trafico-y-a-la-calidad/

http://elgeek.com/

Como que ya debemos actualizar este artico hacia una optimizacion de paginas dinámicas, porque los php invaden la web.

Respecto al punto 7 sobre páginas dinámicas, ¿cual es la razón para que el buscador limite la indexación de estas páginas? El que hace el trabajo es el servidor donde está alojada la web que es el que tiene que devolver páginas estáticas.

10 consejos para optimizar tu sitio para Google

Con eso evitamos que los robots cacheen y archiven nuestras paginas.

Listo!, ahora podemos enviar nuestro sitio web a Google para que lo indexe correctamente.(Traducido y adaptado de 10 things… por El Geek.)

El diskette ha muerto

Pues yo os recomiendo que no lo enterréis tan pronto, que no se sabe cuando puede venir bien… y mas en oficinas o en empresas.

Eso es algo que estoy escuchando desde hace años… una cosa es que desaparezcan, y otra cosa es que se deje de “promocionar” su uso…

sábado, 11 de abril de 2009

viernes, 10 de abril de 2009

jueves, 9 de abril de 2009

Dell lanza computadoras de escritorio Studio todo en uno